De Amerikaanse AI-gigant OpenAI is opnieuw in het nieuws. Dit keer gaat het niet over een nieuw model of een nieuwe functie, maar over een interne reorganisatie. Het zogeheten modelgedragsteam, het team dat bepaalt hoe ChatGPT met gebruikers communiceert en welke "persoonlijkheid" de chatbot heeft, wordt samengevoegd met het posttrainingteam.

Waarom deze stap?

Volgens TechCrunch schreef chief research officer Mark Chen in een interne memo dat het tijd is om het werk van het modelgedragsteam dichter bij de kernontwikkeling van de modellen te brengen. Omdat de persoonlijkheid van ChatGPT inmiddels een essentieel onderdeel is van hoe mensen de technologie ervaren, moet dit nauwer verbonden worden met het team dat zich bezighoudt met de verfijning van het model na de basisopleiding (posttraining).

Het gevolg: veertien onderzoekers verhuizen naar het posttrainingteam, dat voortaan onder leiding staat van Max Schwarzer.

Controverses en druk van buitenaf

De stap komt niet uit de lucht vallen. OpenAI ligt de laatste maanden meermaals onder vuur vanwege het gedrag van zijn modellen. Vorige maand dienden ouders van een zestienjarige jongen een rechtszaak in tegen het bedrijf. Hun zoon pleegde zelfdoding na intensief contact met ChatGPT. Dit leidde tot felle kritiek en de aankondiging van nieuwe functies voor ouderlijk toezicht.

Het benadrukt hoe gevoelig en belangrijk de "persoonlijkheid" van een AI-chatbot is. Een te menselijke, bevestigende of juist misleidende toon kan direct gevolgen hebben voor gebruikers – zeker bij kwetsbare groepen.

Nieuwe rol voor Joanne Jang

Joanne Jang, oprichter en leider van het modelgedragsteam, vertrekt niet bij OpenAI maar start een nieuw initiatief: OAI Labs. Dit team moet nieuwe manieren bedenken en testen voor hoe mensen samenwerken met AI. Jang gaf op X aan dat ze mogelijk wil samenwerken met Jony Ive, de bekende voormalig ontwerper van Apple, die zich eerder dit jaar bij OpenAI aansloot. Voorlopig richt zij zich echter op onderzoeksgebieden waarin ze al meer ervaring heeft.

Wat betekent dit voor ons als gebruikers?

Voor gebruikers van ChatGPT kan de reorganisatie op korte termijn subtiel merkbaar worden. Het model kan:

- anders reageren in gesprekken, bijvoorbeeld neutraler of consistenter;

- meer veiligheidselementen bevatten, zoals waarschuwingen bij gevoelige onderwerpen;

- nieuwe interfaces krijgen, die de interactie met AI menselijker of juist duidelijker begrensd maken.

Wat kunnen HCC-leden hiervan leren?

- Persoonlijkheid in AI is geen bijzaak. Hoe een model reageert, welke toon het aanslaat en welke grenzen het stelt, is minstens zo belangrijk als de technische kwaliteit.

- Kritisch blijven is essentieel. AI kan handig zijn, maar gebruikers moeten alert zijn op misleidende antwoorden, een te vriendelijke bevestiging of het ontbreken van nuance.

- Experimenteren loont. Binnen HCC!ai kun je zelf testen hoe ChatGPT en alternatieven zoals Claude, Gemini en Le Chat van Mistral reageren in vergelijkbare situaties. Door ervaringen te delen leren we samen waar de grenzen en mogelijkheden liggen.

- Let op kwetsbare groepen. Jongeren, ouderen en mensen in kwetsbare situaties hebben meer begeleiding nodig. Het gebruik van ouderlijk toezicht of duidelijke uitleg kan hierbij helpen.

OpenAI schuift zijn teams dichter naar elkaar toe om de persoonlijkheid van ChatGPT serieuzer te verankeren in de ontwikkeling. Voor HCC-leden is dit een goed moment om kritisch mee te kijken, ervaringen uit te wisselen en te begrijpen dat AI niet alleen technologie is, maar ook psychologie.

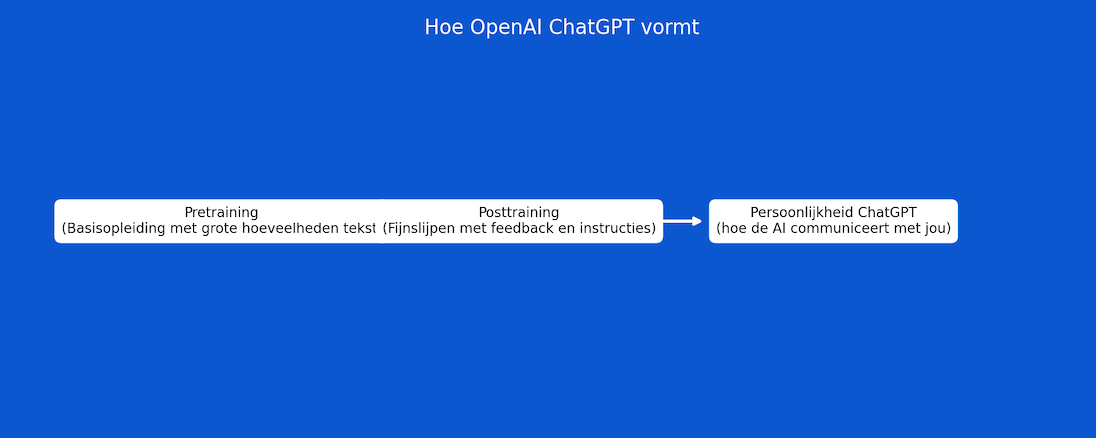

Schema: Hoe ChatGPT zijn persoonlijkheid krijgt

Het proces verloopt in drie stappen:

- Pretraining – het model leert taal door enorme hoeveelheden tekst te verwerken.

- Posttraining – met feedback en instructies wordt het model verfijnd.

- Persoonlijkheid – hier ontstaat de manier waarop ChatGPT met jou communiceert: toon, stijl en grenzen.

Dit schema laat zien waarom de reorganisatie bij OpenAI belangrijk is: de persoonlijkheid van ChatGPT wordt nu nauwer verbonden met de technische kern van het model.