De inzet van kunstmatige intelligentie (AI) in militaire toepassingen groeit in razendsnel tempo. Volgens Politico wordt in de Verenigde Staten gewerkt aan het versneld integreren van de nieuwste AI-systemen in defensiestrategie. Daarmee wil het Pentagon voorbereid zijn op meerdere dreigingen tegelijk, waaronder China en Rusland. Maar experts waarschuwen: de gevaren van een te snelle en onvoldoende geteste toepassing zijn groot.

Hoe AI nu al wordt ingezet

Sofia Romansky, strategisch analist bij het Haags Centrum voor Strategische Studies (HCSS), schetst dat AI steeds vaker wordt gebruikt om enorme hoeveelheden data in realtime te verwerken. Dat kan helpen om sneller en beter beslissingen te nemen in conflictsituaties, waar seconden het verschil kunnen maken.

Ook Nederland maakt al gebruik van AI in Defensie. De marine gebruikt al jaren de Goalkeeper, een volledig geautomatiseerd close-in wapensysteem dat inkomende raketten of vliegtuigen uitschakelt. Het systeem combineert radar, software en een Gatling-geweer en geldt als één van de laatste verdedigingslagen van een marineschip.

Ethische en juridische risico’s

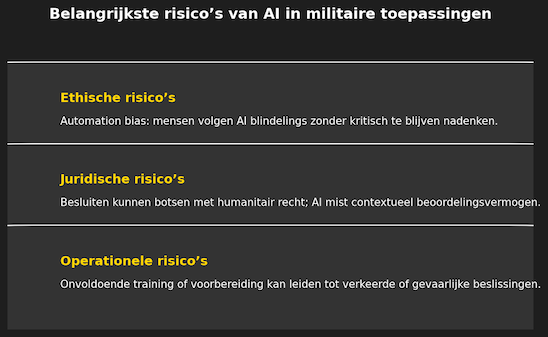

De zorgen over militaire AI liggen vooral op drie vlakken:

- Ethisch: mensen kunnen geneigd zijn AI blindelings te volgen (automation bias), ook wanneer het systeem verkeerde aannames maakt.

- Juridisch: AI-systemen zijn slecht in contextafhankelijke beslissingen, waardoor het humanitair recht in gevaar kan komen.

- Operationeel: zonder goede training en voorbereiding neemt de kans toe dat AI verkeerde beslissingen versterkt.

Romansky wijst op het risico dat drones of andere autonome systemen getraind zijn in één omgeving, maar totaal anders reageren in een andere context.

Bezorgdheid over autonome wapensystemen

Met de opkomst van generatieve AI – modellen die mensachtige interacties bieden – groeit de zorg dat wapensystemen op termijn zelfstandig beslissingen kunnen nemen. Denk aan zwermen drones die zonder menselijke tussenkomst aanvallen uitvoeren. Het gevaar is dat zulke systemen onvoorspelbaar geweld gebruiken, zonder menselijke controle.

Menselijke controle blijft essentieel

Romansky benadrukt dat AI altijd een ondersteunend instrument moet blijven. Commandanten moeten begrijpen hoe AI tot aanbevelingen komt en kritisch blijven nadenken. Vooral beslissingen met grote gevolgen – zoals het gebruik van nucleaire wapens – mogen nooit aan AI worden overgelaten.

Toch blijft AI in militaire context een strategisch thema. Grote mogendheden investeren fors, waardoor de technologie onderdeel is geworden van een internationale wapenwedloop. Het advies van experts is dan ook helder: ga voorzichtig en verantwoord om met militaire AI, en houd de mens altijd eindverantwoordelijk.