AI-chatbots zoals ChatGPT, Gemini, Claude en Grok zijn voor veel mensen inmiddels een vast hulpmiddel geworden. Ze beantwoorden vragen, vatten teksten samen, analyseren afbeeldingen en functioneren steeds vaker als alternatief voor zoekmachines. Maar hoe betrouwbaar zijn die antwoorden eigenlijk?

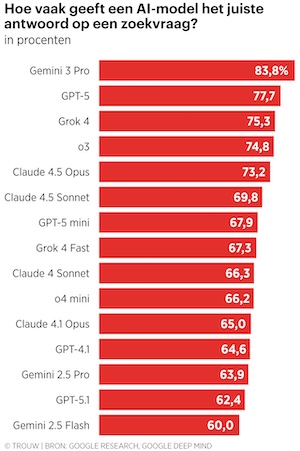

Uit recent onderzoek van Google Research en DeepMind blijkt dat dat vertrouwen lang niet altijd terecht is. In het beste geval geven AI-chatbots ongeveer één op de drie keer onjuiste informatie. Bij sommige modellen loopt dat zelfs op tot 70 procent foutieve antwoorden.

Onderzoek naar feitelijke juistheid

In het zogenoemde Facts-onderzoek werden vijftien verschillende versies van populaire AI-modellen getest op vier vaardigheden:

* het correct beantwoorden van zoekvragen

* het overeenkomen van antwoorden met gebruikte bronnen

* feitelijke kennis

* et herkennen en interpreteren van afbeeldingen

De resultaten zijn op z’n minst zorgelijk. Zelfs de best scorende chatbot, Gemini 2.5 Pro, gaf bij het herkennen van afbeeldingen in slechts 47 procent van de gevallen het juiste antwoord. Bij zoekvragen deed het beste model het beter, maar ook daar zat het nog bijna 17 procent van de tijd fout. Opvallend is dat vooral “lichtere” of snellere versies van modellen, zoals Gemini Flash, veel slechter scoren: tot 40 procent onjuiste antwoorden.

Waarom dit juist nu een probleem is

Veel gebruikers zetten AI-chatbots in als veredelde zoekmachine. In plaats van zelf bronnen te raadplegen, wordt het AI-antwoord direct overgenomen. Dat is precies waar het risico zit. Volgens Pascal Wiggers, lector Verantwoorde IT aan de Hogeschool van Amsterdam, zijn het niet de grove fouten die gevaarlijk zijn, maar juist de subtiele. Een verkeerd jaartal, een fout detail of een net-niet-kloppende uitleg klinkt vaak overtuigend, maar kan onopgemerkt verkeerd worden gebruikt.

En omdat AI-antwoorden vaak vloeiend en zelfverzekerd worden geformuleerd, wekken ze snel vertrouwen. “Je moet oppassen als je denkt: het klinkt best plausibel,” aldus Wiggers.

Hallucinaties blijven bestaan

AI-systemen “hallucineren”: ze verzinnen informatie wanneer ze het antwoord niet zeker weten. Dat is geen tijdelijke kinderziekte, maar een fundamenteel kenmerk van grote taalmodellen. Ze voorspellen woorden op basis van waarschijnlijkheid, niet op basis van begrip.

Hoewel modellen snel verbeteren — fouten zoals het verkeerd vergelijken van getallen worden soms binnen een week opgelost — betekent dat niet dat AI ooit volledig betrouwbaar wordt. Antwoorden blijven deels willekeurig en kunnen van dag tot dag verschillen.

Wat betekent dit concreet voor HCC-leden?

Voor HCC-leden is dit onderzoek vooral een oproep tot bewust en kritisch gebruik van AI:

* Gebruik AI als hulpmiddel, niet als autoriteit

* Controleer feiten altijd bij belangrijke beslissingen

* Vertrouw AI niet blind bij juridische, medische, financiële of technische vragen

* Wees extra alert bij samenvattingen en beeldanalyses

* Klik door naar originele bronnen, zeker bij nieuws en cijfers

Voor hobbyisten, programmeurs, beleggers, fotografen en andere HCC-doelgroepen geldt: AI kan enorm helpen bij inspiratie, eerste analyses en uitleg, maar niet als eindstation.

AI blijft waardevol – mits goed gebruikt

Net als een Formule-1-auto op het circuit kan AI indrukwekkende prestaties leveren in gecontroleerde omstandigheden. Maar dat zegt weinig over hoe betrouwbaar het systeem is in het dagelijks gebruik. Voor HCC!ai ligt hier een belangrijke taak: leden helpen begrijpen wat AI wel kan, wat het niet kan en waar de risico’s liggen. Niet door angst te zaaien, maar door digitale vaardigheden en kritisch denken te versterken.

AI is krachtig gereedschap. Maar gereedschap werkt alleen veilig in handen van iemand die weet hoe het werkt — en wanneer je beter even kunt controleren.